Tin Công Nghệ

Trend máy chủ AI sử dụng GPU, NVLink trong 2025

AI ngày nay không chỉ là phần mềm chạy trên máy chủ bình thường nữa – nó đã thúc đẩy tiến hóa hệ thống phần cứng toàn diện. Máy chủ AI năm 2025 được định hình lại qua ba trụ cột quan trọng: GPU chuyên dụng hiệu năng cao, chuẩn kết nối siêu nhanh NVLink, và mô hình kiến trúc mới tối ưu toàn bộ hệ sinh thái tính toán. Bài viết này đi sâu khai phá các xu hướng ấy, giúp bạn nắm rõ cách các yếu tố này cộng hưởng để tạo nên máy chủ AI thế hệ tiếp theo!

Mục lục

Sự trỗi dậy của GPU Datacenter

GPU hiện đã trở thành trái tim của máy chủ AI, chuyển từ vai trò tăng tốc đồ họa sang thành phần compute chính cho training và inference. Trong năm 2025, các dòng GPU mới như Blackwell (Nvidia) và MI400 (AMD) đã đặt ra tiêu chuẩn mới về hiệu hiệu năng, khả năng mở rộng và đa nhiệm.

- GPU Blackwell sử dụng tiến trình 4nm mới nhất, có khả năng tính toán hàng chục petaflops chuyên biệt cho AI. Kiến trúc Tensor Core thế hệ mới cũng cải thiện khả năng xử lý mô hình lớn và siêu lớn.

- AMD không đứng ngoài cuộc: GPU MI400/MI350 tích hợp kiến trúc bộ nhớ nhanh, tổ chức lại nhân tăng tốc dữ liệu AI, và tạo ra giải pháp thay thế cạnh tranh khi triển khai ở quy mô lớn.

- Hai giải pháp đến từ Nvidia và AMD được thiết kế để có thể chạy được hàng trăm GPU trong một cụm, phục vụ nhu cầu của các trung tâm dữ liệu AI công nghiệp.

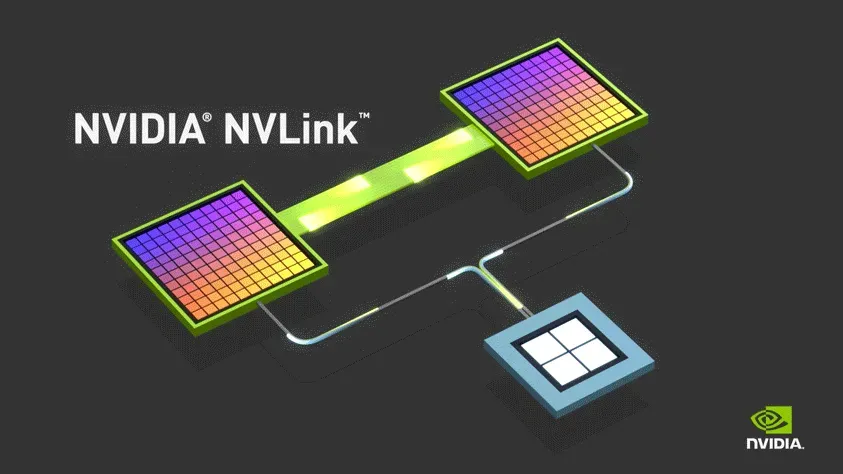

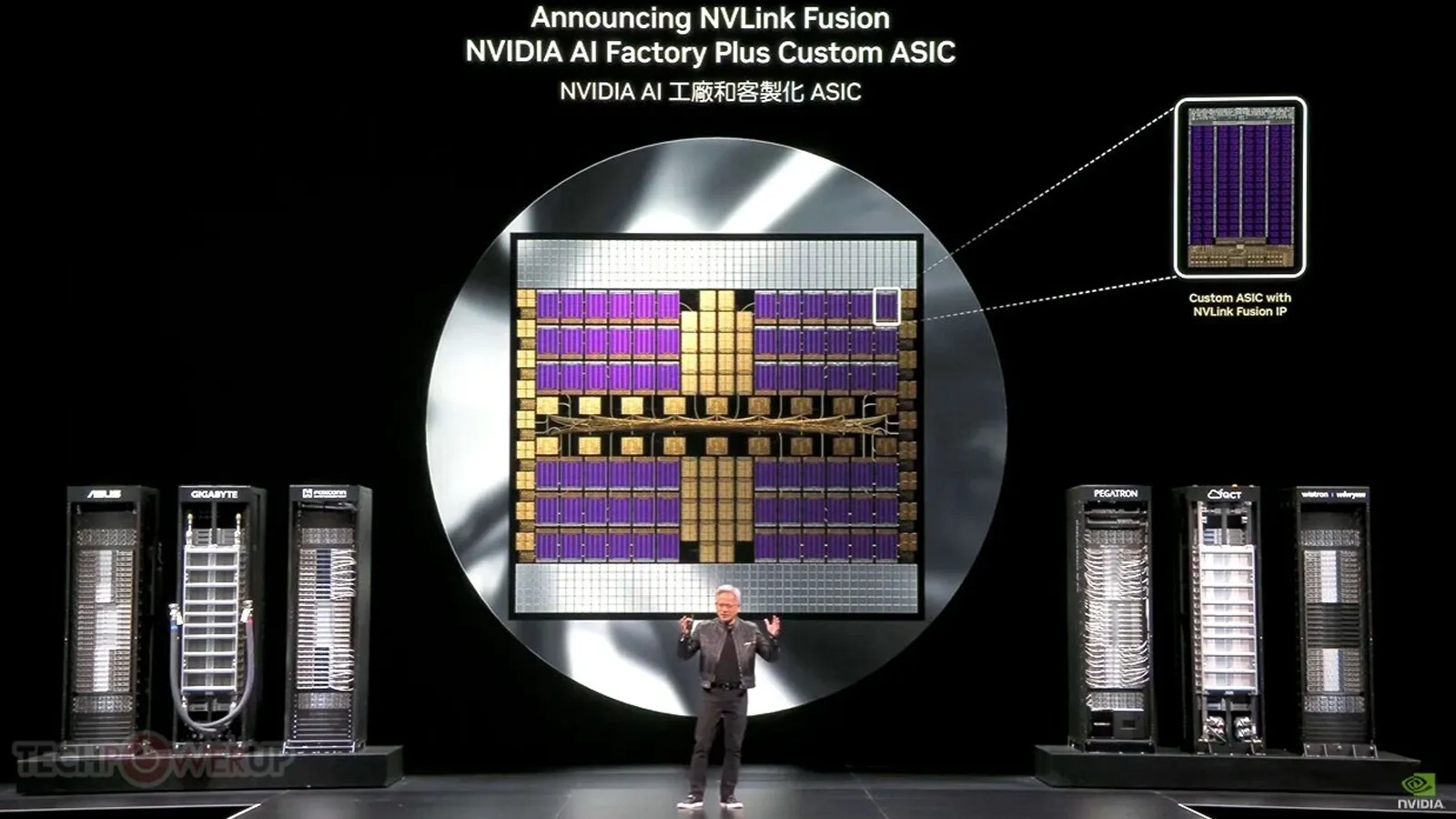

NVLink Fusion và hệ sinh thái mở rộng

Chuẩn NVLink Fusion đã tái định nghĩa kết nối giữa các GPU và giữa GPU với CPU, ASIC trong các máy chủ AI. Nó tăng gấp nhiều lần băng thông, giảm đáng kể độ trễ, đồng thời mở đường cho hệ sinh thái mở gồm đa chip từ nhiều hãng.

- NVLink Fusion hiện hỗ trợ băng thông vượt quá 1 TB/s, giúp dữ liệu di chuyển giữa GPU nhanh hơn nhiều so với PCIe truyền thống. Điều này đặc biệt quan trọng khi thực hiện khối lượng dữ liệu lớn cho ChatGPT hoặc các mô hình generative AI.

- Hệ sinh thái hiện đã không chỉ giới hạn GPU Nvidia – các công ty như MediaTek, Marvell, Fujitsu và Qualcomm đang tích hợp CPU hoặc bộ tăng tốc riêng kết nối qua NVLink để tạo nên máy chủ AI tùy chỉnh.

Nhờ vậy, những kiến trúc “AI factory” hybrid có thể tận dụng chip tối ưu cho từng workload – một bước thay đổi nền tảng trong cách xây dựng hệ thống.

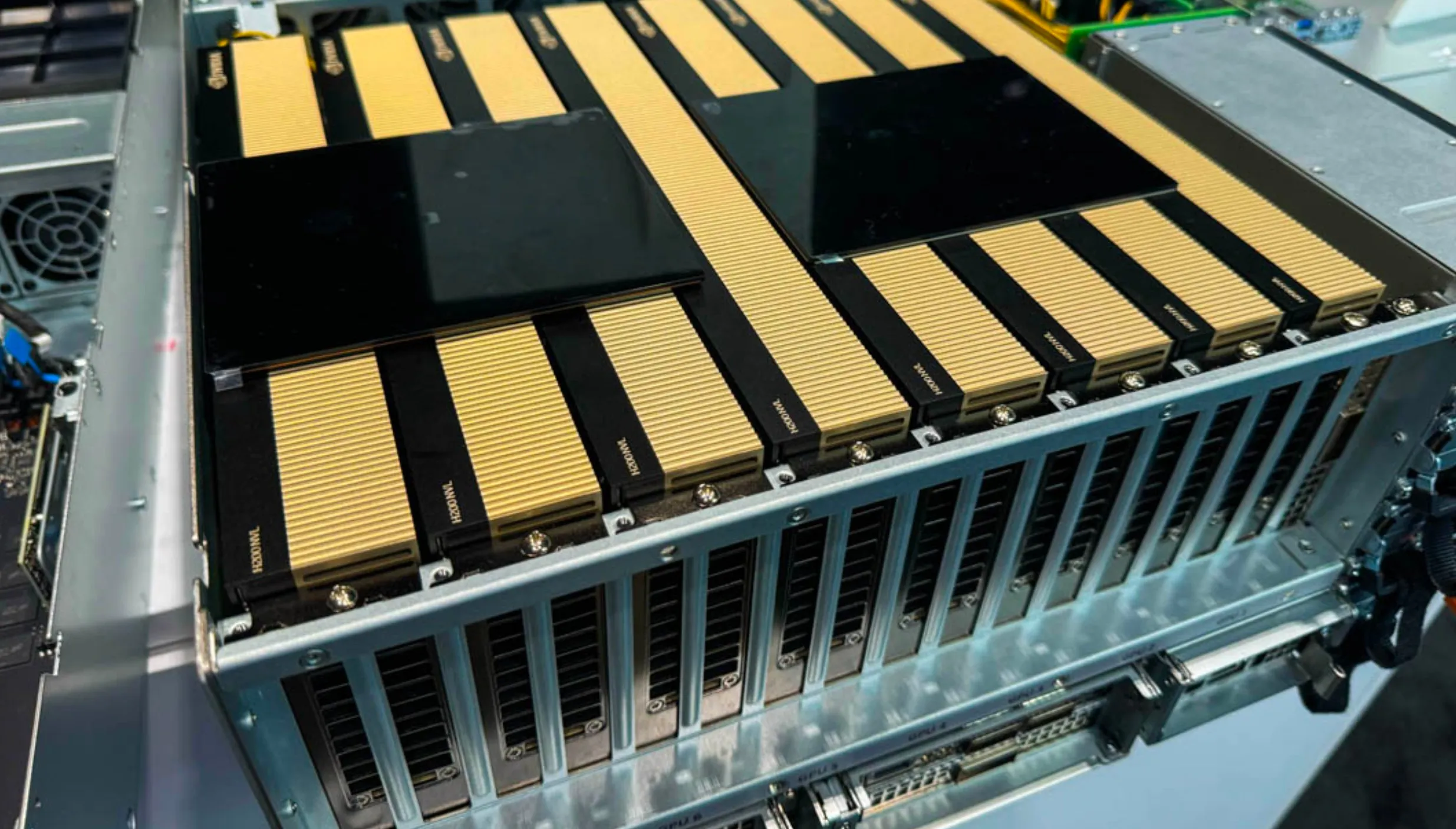

Mô hình server rack thế hệ mới

Server rack dành cho AI ngày càng được thiết kế không chỉ để chứa CPU và GPU, mà còn tích hợp thêm DPU, switch tốc độ cao, và hệ thống làm mát tiên tiến. Mô hình này hướng đến mục tiêu “AI factory” toàn diện: kiến trúc có thể mở rộng linh hoạt và tối ưu ở mỗi thành phần.

- Các hệ thống như NVL576 của Nvidia tích hợp hàng trăm GPU thế hệ mới, đi kèm switch InfiniBand tốc độ cao và module quang hỗ trợ kết nối toàn diện trong rack.

- AMD cũng có câu trả lời với Helios – rack tích hợp GPU MI400, CPU EPYC thế hệ mới, DPU Pensando – nhằm cạnh tranh cả về hiệu năng và chi phí.

- Các node này không chỉ là các “vùng compute” mà còn bao gồm hệ thống mạng quang và bộ điều khiển mạng (DPU) nhằm giảm tải cho GPU, nâng cao hiệu suất toàn hệ thống.

GPU đa thể (Multi‑Instance GPU)

Khái niệm MIG (Multi-Instance GPU) giúp chia nhỏ một GPU vật lý thành nhiều đơn vị logic, cho phép chạy đồng thời nhiều workload đa dạng trên cùng một phần cứng mà không phải dùng nhiều GPU đơn lẻ.

- Một GPU như Nvidia A100/H100 có thể tạo ra tới 8 instance độc lập, mỗi instance có tài nguyên riêng để chạy inference nhỏ hoặc tác vụ nhẹ.

- Đây là giải pháp tiết kiệm phần cứng hiệu quả, đặc biệt khi một số workload không cần toàn bộ sức mạnh của GPU.

- MIG giúp tăng tổng throughput lên nhiều lần, đồng thời giảm độ trễ tail – đặc biệt quan trọng trong các hệ thống phân phối dịch vụ AI.

Hạ tầng mạng và làm mát hiện đại

Khi tích hợp nhiều GPU và đạt băng thông dữ liệu cực lớn, thiết kế hạ tầng mạng và làm mát phải được nâng cấp toàn diện. Những thay đổi này đảm bảo hiệu năng ổn định và độ tin cậy trong môi trường hoạt động 24/7.

- Công nghệ Co‑Packaged Optics (CPO) đưa quang học gần nhân xử lý hơn, giúp giảm độ trễ và tăng băng thông giữa các GPU và switch trong rack.

- Các giải pháp mạng như InfiniBand Quantum‑X, Spectrum‑X Ethernet kết hợp với DPU như BlueField giúp xử lý packet hiệu quả mà không ảnh hưởng tải lên GPU.

- Về làm mát, hình thức liquid-cooling trực tiếp (cold plate) hoặc phân tầng nhiệt (separate IT/power zones) giúp duy trì nhiệt độ an toàn, tăng hiệu suất điện năng hệ thống.

Xem thêm máy chủ R660xs chính hãng

Chi phí và khả năng mở rộng

Giới thiệu: Mặc dù hiệu năng là trọng tâm, nhưng yếu tố ROI và khả năng mở rộng hệ thống trong thực tế mới là điều quan trọng khi triển khai server AI quy mô lớn, như ở các cloud provider và trung tâm doanh nghiệp.

- GPU AMD như MI355X được quảng bá mang lại số lượng token xử lý trên mỗi đô la đầu tư cao hơn, cho thấy khả năng cạnh tranh trực tiếp với Nvidia trên phương diện kinh tế.

- Nvidia thì mở rộng NVLink Fusion, hỗ trợ tích hợp chip tùy chỉnh để doanh nghiệp và cloud provider có thể xây dựng hệ thống hybrid giúp giảm phụ thuộc và linh hoạt hơn…

- Nhiều nhà cung cấp cloud lớn như AWS, GCP hay Azure đang phát triển những chip nội bộ để bù đắp chi phí sử dụng GPU, đồng thời giảm ràng buộc với Nvidia.

Mạng lưới hệ sinh thái và chiến lược quốc gia

Server AI ngày nay không chỉ là phần cứng độc lập, mà là thành phần nằm trong hệ sinh thái rộng lớn liên kết giữa chính phủ, ngành chip và các tập đoàn toàn cầu. “AI factory” là một phần trong chiến lược phát triển kỹ thuật và an ninh quốc gia.

- NVLink Fusion cùng với sự hợp tác từ các nhà sản xuất chip cho phép tạo nền tảng “penisa turnkey” cho server hybrid – tích hợp GPU, CPU và ASIC, đa dạng hóa nguồn cung.

- Các quốc gia quan trọng như Hàn Quốc, Nhật Bản, Đài Loan xây dựng hệ thống AI nội địa bằng cách sử dụng chip do hãng trong nước phát triển và tích hợp vào chassis máy chủ, giảm phụ thuộc nước ngoài.

- Đây là một bước tiến lớn về kiến tạo chuỗi cung ứng toàn cầu nhưng vẫn đảm bảo an ninh quốc gia, từ phần mềm đến phần cứng và kết nối.

Tầm nhìn cho năm 2026–2027

Chu kỳ nâng cấp GPU không dừng lại ở 2025. Những thế hệ tiếp theo như Rubin (2026) và Feynman (2027+) hứa hẹn tiếp tục tăng quán tính hiệu năng, mật độ bộ nhớ và băng thông – hướng đến mục tiêu exascale AI.

- Rubin sẽ được sản xuất bằng tiến trình 3nm, trang bị bộ nhớ HBM4, hiệu suất nhân đôi so với Blackwell và hỗ trợ cấu hình dual GPU “Rubin Ultra”.

- Định hướng tiếp theo – Feynman – sẽ tích hợp mô hình chiplet nhân đôi, tối ưu bộ nhớ nội, kết hợp NVLink Fusion và quang học co‑packaged để vượt đỉnh hiệu năng exascale.

- Các thế hệ này không chỉ phục vụ generative AI quy mô lớn mà còn tối ưu hóa inference thời gian thực, huấn luyện mô hình có quy mô hàng chục tỷ tham số.

Tạm kết

Năm 2025 là đoạn giữa của một cuộc cách mạng phần cứng AI: từ GPU tiên tiến, hệ sinh thái kết nối NVLink mở rộng, đến mô hình rack server tích hợp đa lớp compute, mạng và làm mát. AMD và Nvidia đang cạnh tranh trực tiếp cả về hiệu năng và ROI. “AI factory” không còn là câu chuyện viễn tưởng mà đã bắt đầu triển khai ở các đơn vị doanh nghiệp và lãnh đạo quốc gia.

Cuối cùng, khi bước vào giai đoạn Rubin và Feynman, chúng ta sẽ chứng kiến sự chuyển mình của máy chủ AI từ đơn thuần là phân phối compute, thành nền tảng toàn diện, hỗ trợ mọi khía cạnh của kinh tế kỹ thuật số – từ mô hình lớn, inference thời gian thực, đến phát triển chip nội địa. Nếu bạn cần thêm bản phân tích chỉ số hiệu năng, case study triển khai, hoặc benchmark giữa các GPU/NVIDIA vs AMD, mình sẵn sàng hỗ trợ!

Không thể bỏ lỡ máy chủ ML350 Gen11

Có thể bạn quan tâm